A través de este proceso, se obtiene la información necesaria para entender mejor una situación, identificar patrones y tomar decisiones con fundamento.

La recolección de datos es un paso clave en cualquier investigación o proyecto. Si los datos no son precisos o confiables, los resultados pueden ser engañosos. Por eso, es importante aplicar técnicas de recolección de datos que aseguren la calidad de la información que se recopila.

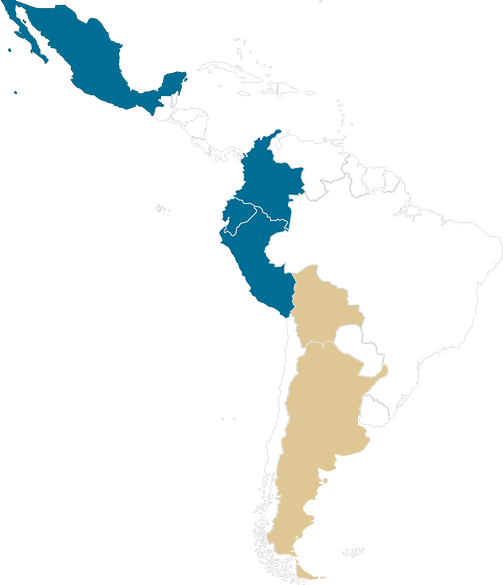

En áreas como las que se estudia en la Maestría en Ciencia de Datos y Big Data o la Maestría en Inteligencia de Negocios la precisión de los datos es vital. La data bien recolectada es la base para desarrollar análisis que permitan tomar decisiones acertadas. Además, contar con buena información te ayuda a anticipar problemas y definir estrategias más efectivas. De hecho, es la única maestría en México que te capacitará en el ciclo completo de un proyecto de big data, desde la recolección de datos y captura de datos hasta el almacenamiento, procesamiento, análisis e interpretación y visualización de estos.

Qué son las técnicas de recolección de datos

Son herramientas que te permiten obtener la información necesaria para analizar una situación o resolver una pregunta de investigación.

Estas técnicas son esenciales para garantizar que los datos que recolectas sean útiles, confiables y relevantes. Si no eliges el método adecuado, podrías terminar con información incompleta o inexacta, lo que afectaría el análisis final.

Debes tener en cuenta que el concepto de recolección de datos se refiere al proceso de recoger y organizar información de diversas fuentes. Además, puede hacerse de muchas maneras.

Al entender qué son las técnicas de recolección de datos, puedes seleccionar las que mejor se ajusten a tus objetivos y así asegurar que los resultados sean precisos y útiles para tomar decisiones.

Tipos de recolección de datos

¿Cuáles son las técnicas de recolección de datos? Existen dos tipos de recolección de datos, y cada uno tiene su propio enfoque para obtener la información necesaria.

— Recolección de datos cuantitativos: se enfoca en obtener información numérica que puede medirse y analizarse de manera estadística.

— Recolección de datos cualitativos: busca captar experiencias, opiniones o comportamientos. Estos datos no se traducen en números, sino en descripciones detalladas que ayudan a entender mejor un fenómeno.

La clave está en la correcta selección de datos, es decir, elegir los métodos adecuados para tu investigación. La combinación de técnicas de recolección de datos, tanto cuantitativas como cualitativas, te permite obtener una visión más completa y rica de la realidad que estás investigando.

Instrumentos y métodos de recolección de datos

Existen diversos instrumentos y métodos de recolección de datos que permiten obtener información precisa. Entre ellos:

- Encuestas: son cuestionarios estructurados que se aplican a un grupo amplio de personas. Se pueden realizar de manera presencial, por teléfono o en línea. Permiten recolectar datos de forma rápida y eficiente.

- Entrevistas: consisten en hacer preguntas directas a una persona o grupo, ya sea de manera estructurada (con preguntas fijas) o semiestructurada (más flexible). Es ideal para obtener información detallada.

- Observación: este método implica observar el comportamiento de los sujetos en su entorno natural sin intervenir. Es útil para estudios de comportamiento o para entender cómo actúan las personas en situaciones reales.

- Grupos focales (focus groups): se reúnen entre 6 y 12 personas para discutir un tema específico. El moderador guía la conversación para obtener percepciones, opiniones o ideas sobre un tema en particular.

- Revisión de registros: consiste en analizar información existente, como registros médicos, informes o bases de datos, para extraer datos relevantes sin tener que realizar nuevas encuestas o entrevistas.

- Pruebas o experimentos: se trata de aplicar pruebas físicas, mentales o técnicas específicas para medir habilidades, conocimientos o respuestas ante ciertos estímulos. Son muy útiles para estudios en áreas científicas o académicas.

Cada uno de estos instrumentos de recolección de datos tiene sus ventajas y desafíos. La elección dependerá de los objetivos de la investigación y del tipo de información que se busque recolectar.

Técnicas de recolección de datos en Big Data

Estos son algunos ejemplos de técnicas de recolección de datos que se utilizan en Big Data:

1. Extracción de datos de registros (Logs)

Una de las técnicas más comunes para recolectar datos es la captura de los registros de eventos o logs. Estos registros son generados automáticamente por sistemas, aplicaciones y servidores cada vez que ocurre un evento significativo, como una transacción, un inicio de sesión o un error. En el contexto de big data, los logs de aplicaciones web, servidores y dispositivos IoT proporcionan una rica fuente de datos que se puede analizar para monitorear rendimiento, detectar anomalías o predecir comportamientos.

Herramientas que se utilizan:

Apache Flume: Usado para recolectar, agregar y mover grandes cantidades de datos de logs a un sistema de almacenamiento centralizado.

Logstash: Una herramienta para recopilar, analizar y transformar datos de logs de múltiples fuentes.

2. Rastreo Web (Web Scraping)

El web scraping es otra técnica fundamental que se utiliza para extraer información de sitios web. Implica el uso de bots que acceden a páginas web, recuperan su contenido (HTML, XML, JSON) y lo procesan para extraer datos específicos. Esta técnica es particularmente útil para capturar datos no estructurados o semiestructurados de sitios web públicos, como datos de redes sociales, reseñas de productos o noticias.

Herramientas utilizadas:

BeautifulSoup y Scrapy: Librerías en Python especializadas en la extracción y estructuración de datos desde el contenido web.

Apache Nutch: Un framework extensible de rastreo web que puede usarse junto a Apache Hadoop para realizar el procesamiento de grandes volúmenes de datos de sitios web.

3. Sensores y dispositivos IoT

Con la expansión del Internet de las Cosas (IoT), la recolección de datos de dispositivos inteligentes y sensores ha tomado relevancia. Los sensores IoT generan datos en tiempo real que provienen de dispositivos conectados, como cámaras, termostatos, wearables, entre otros. Esta información, que puede ser en formato de secuencias de datos o flujos de tiempo real, es clave para aplicaciones como el monitoreo de entornos, la automatización industrial y el mantenimiento predictivo.

Herramientas utilizadas:

Apache Kafka: Se usa para gestionar y procesar grandes flujos de datos en tiempo real provenientes de dispositivos IoT.

AWS IoT Core: Plataforma en la nube que facilita la conexión y gestión de millones de dispositivos IoT para recolectar datos.

4. Recolección de datos de redes sociales

Las plataformas de redes sociales son una fuente rica en datos no estructurados, como publicaciones, comentarios, likes, shares, imágenes y videos. Las empresas utilizan APIs ofrecidas por las redes sociales para recolectar datos a gran escala con el objetivo de analizar tendencias, medir la satisfacción del cliente o realizar estudios de mercado. El análisis de sentimiento y la minería de opiniones son casos comunes de uso en este contexto.

Herramientas utilizadas:

Twitter API, Facebook Graph API: Son interfaces que permiten a los desarrolladores acceder y recolectar datos desde las respectivas plataformas.

Hootsuite o Buffer: Herramientas que ayudan a la gestión y análisis de datos provenientes de múltiples redes sociales.

5. Extracción de Datos de Bases de Datos Relacionales y NoSQL

En el mundo del big data, es crucial la capacidad de recolectar datos tanto de bases de datos tradicionales (relacionales) como de bases de datos NoSQL que están optimizadas para grandes volúmenes de datos no estructurados o semiestructurados. La extracción de datos desde estas fuentes implica la ejecución de consultas eficientes para obtener grandes cantidades de información y luego transformarla o integrarla en sistemas de almacenamiento y análisis de big data.

Herramientas utilizadas:

Sqoop: Herramienta para la transferencia de grandes volúmenes de datos entre bases de datos relacionales y sistemas Hadoop.

Cassandra, MongoDB: Son bases de datos NoSQL que almacenan grandes cantidades de datos distribuidos, perfectas para los entornos de big data.

6. APIs y Fuentes Externas

El acceso a datos a través de APIs es otra técnica extendida en big data, sobre todo cuando se requiere recolectar datos de servicios externos, como datos meteorológicos, económicos o demográficos. Estas interfaces proporcionan un acceso estructurado a datos en tiempo real o históricos que pueden complementar fuentes internas.

Herramientas utilizadas:

REST APIs y SOAP APIs: Son protocolos que permiten la interacción entre sistemas y la transferencia de datos en formatos como JSON o XML.

Postman: Una herramienta muy usada para interactuar y probar APIs antes de integrarlas a sistemas más grandes de recolección de datos.

Importancia de las técnicas de recolección de datos

Las técnicas de recolección de datos son fundamentales para obtener información confiable que permita tomar decisiones acertadas. Si los datos no se recogen de forma adecuada, los análisis y conclusiones pueden ser incorrectos o imprecisos. Por eso, es clave elegir la técnica adecuada según el tipo de datos que se necesiten y el contexto del estudio.

El diseño de técnicas de recolección de datos juega un papel crucial en este proceso. Adaptar las herramientas y métodos a los objetivos de la investigación asegura que los datos recolectados sean relevantes y útiles.