Los LLM (Large Language Models) son sistemas de Inteligencia Artificial (IA) diseñados para procesar y entender el lenguaje humano.

Desde los orígenes de la Inteligencia Artificial (IA), uno de los grandes objetivos ha sido lograr que las máquinas puedan interactuar de forma natural con los seres humanos, tal como lo hacemos las personas. En la década de 1950, Alan Turing se preguntó si las máquinas podían llegar a considerarse inteligentes y, para explorar esta idea, propuso la conocida “Prueba de Turing”. Esta prueba consiste en un experimento en el que una persona que funge como evaluador, interactúa sin saber con quién habla, con otra persona y con una máquina. Si el evaluador no logra distinguir cuál es cuál, y la máquina consigue mantener una conversación que parezca humana, se considera que ha mostrado un comportamiento inteligente y ha pasado la prueba de Turing.

Los primeros enfoques en el área de Inteligencia Artificial se basaban en sistemas simples de traducción automática apoyados en reglas lingüísticas. Sin embargo, estos métodos resultaban muy limitados y no podían manejar la complejidad ni la ambigüedad del lenguaje humano. Décadas más tarde, el avance del aprendizaje profundo dio lugar a modelos más potentes, capaces de comprender y generar texto de manera más natural y contextual. Hoy en día, herramientas como ChatGPT, DeepSeek, Claude o Gemini han popularizado el uso de estos modelos avanzados de lenguaje, que ya forman parte de nuestra vida cotidiana y se emplean en tareas tan diversas como la asistencia virtual, la educación, la generación de contenido y el apoyo en la programación. Esta evolución en la forma en que las máquinas procesan el lenguaje ha dado lugar a los Large Language Models (LLM).

¿Qué es el Procesamiento de Lenguaje Natural (PLN)?

El Procesamiento de Lenguaje Natural (PLN), conocido internacionalmente como NLP por sus siglas en inglés, es una rama de la IA que busca que las computadoras puedan entender, interpretar, generar y manipular el lenguaje humano. Antes de los modelos de lenguaje grandes, el procesamiento de lenguaje natural se apoyaba en reglas manuales y modelos estadísticos, que funcionaban en tareas muy específicas como la detección de spam o la traducción básica. Estos métodos no eran capaces de manejar instrucciones complejas o generar texto coherente. La llegada de los modelos basados en Transformers y grandes volúmenes de datos cambió radicalmente este panorama, permitiendo que los sistemas actuales comprendan mejor el contexto y los matices del lenguaje, y puedan abordar una gran variedad de tareas de forma más natural y coherente. Este avance dio origen a una nueva generación de modelos conocidos como Large Language Models (LLM), que han llevado el procesamiento de lenguaje natural el procesamiento a una nueva etapa, con capacidades que antes eran impensables. En la siguiente sección exploraremos qué son estos modelos y por qué se consideran ‘Large y su relevancia.

¿Qué son los LLM y por qué se consideran “Large”?

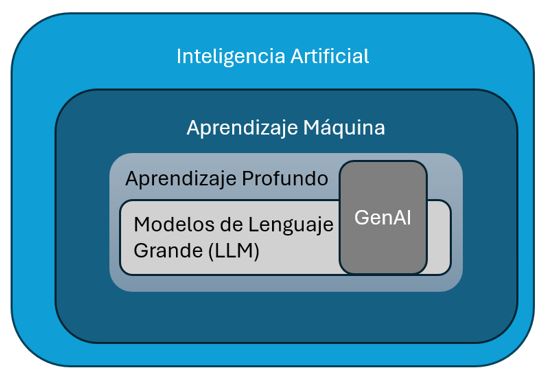

Los LLM forman parte de un campo más amplio conocido como Inteligencia Artificial Generativa (GenAI). La GenAI abarca tecnologías capaces de crear contenido nuevo, como texto, imágenes, música o video, a partir de patrones aprendidos. Dentro de este universo, los LLM son los modelos especializados en lenguaje, y son los responsables de que hoy podamos interactuar con sistemas como ChatGPT o Gemini de una manera natural. Los LLM son el motor del lenguaje dentro de la GenAI: gracias a ellos, los sistemas pueden crear contenido textual y mantener conversaciones con fluidez.

La palabra “Large” se refiere tanto a los datos (cientos de miles de millones de palabras) como al tamaño del modelo, que puede tener miles de millones de parámetros o “conexiones” internas. Esta escala les permite aprender relaciones muy sutiles en el lenguaje. Gracias a su tamaño y a la complejidad de su arquitectura, son capaces de generar respuestas coherentes, contextualizadas y adaptadas a diferentes tareas.

Figura 1. Relación entre Inteligencia Artificial, Aprendizaje Automático, Aprendizaje Profundo, Modelos de Lenguaje Grande (LLM) y GenAI. Inteligencia Artificial (sistemas con inteligencia similar a la humana), Machine Learning (algoritmos que aprenden reglas automáticamente a partir de los datos), Deep Learning (aprendizaje automático con redes neuronales compuestas por muchas capas), LLM (red neuronal profunda para analizar y generar texto similar al humano) y GenAI (la GenAI implica el uso de redes neuronales profundas para crear contenido nuevo, como texto, imágenes u otras formas de contenido). Elaboración propia con base en Raschka (2024).

Estos modelos, conocidos como Large Language Models (LLM), son redes neuronales profundas entrenadas con cantidades masivas de texto. Están construidos sobre la arquitectura de Transformers, la misma que revolucionó el PLN, y gracias a ella pueden analizar el contexto completo de un texto, encontrar relaciones complejas entre palabras y generar respuestas de manera coherente y relevante.

La arquitectura Transformers marcó un hito en el procesamiento de lenguaje natural, al sustituir modelos secuenciales tradicionales por un enfoque mucho más eficiente y capaz de trabajar en paralelo. La gran aportación de los Transformers es el mecanismo de autoatención (self‑attention), que permite a los modelos identificar qué palabras o fragmentos del texto son más relevantes en relación con los demás, incluso cuando están muy alejados entre sí. Gracias a esto, los Modelos de Lenguaje Grande (LLM) pueden captar relaciones de largo alcance, comprender mejor el contexto y generar textos coherentes, naturales y ajustados a cada situación.

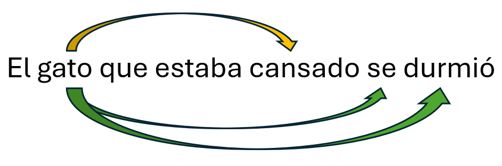

Figura 2. Ejemplo de auto‑atención: el modelo identifica y pondera las palabras relacionadas en una oración, incluso cuando están separadas, para comprender mejor el contexto.

La figura 2 muestra de forma sencilla cómo funciona el mecanismo de auto‑atención en un modelo tipo Transformer. En la oración “El gato que estaba cansado se durmió”, el modelo es capaz de detectar qué palabras tienen más relación entre sí, incluso cuando están separadas. Así, identifica que “gato” se conecta principalmente con “se durmió” y también con “cansado”, asignando mayor ponderación a estas relaciones para comprender el sentido global de la frase. Esta capacidad de analizar todas las palabras en paralelo y establecer conexiones de contexto es una de las claves que diferencia a los LLM de los modelos anteriores.

¿Por qué son relevantes?

La relevancia de los LLM está en que han ampliado el alcance de la inteligencia artificial: pasamos de modelos entrenados para tareas muy específicas a modelos generales que pueden adaptarse a muchas situaciones sin ser reentrenados desde cero.

Hoy estos modelos son capaces de generar texto, traducir, resumir, responder preguntas, analizar sentimientos, escribir código o asistir en tareas creativas.

Lo más sorprendente es que muestran “capacidades emergentes”: realizan tareas para las que no fueron entrenados explícitamente, como traducir o razonar, gracias a la escala de su entrenamiento.

Algunas de las principales aplicaciones son:

- Chatbots y asistentes virtuales (ChatGPT, DeepSeek, Gemini).

- Traducción automática contextual.

- Creación de contenido: artículos, correos, guiones, poemas.

- Apoyo en programación: generación y corrección de código.

- Búsqueda avanzada y resumen de información (por ejemplo, en medicina o derecho).

- Educación personalizada y generación de ejercicios.

- Modelos especializados, como BloombergGPT para finanzas o LLM médicos, entrenados en datos específicos, que ofrecen respuestas mucho más precisas en sus dominios.

Conclusión

Los Large Language Models han marcado un antes y un después en la historia de la inteligencia artificial. Por primera vez, una sola tecnología puede interactuar con nosotros de manera flexible y natural. Esto los convierte en herramientas poderosas, presentes hoy en áreas como la educación, el derecho, la mercadotecnia, la ciencia y muchas otras.

Aunque todavía quedan retos como el manejo de sesgos, la precisión y la ética en su uso, los LLM están más cerca que nunca de cumplir la visión que Turing imaginó: máquinas que nos entienden y colaboran con nosotros en lenguaje humano.

Autora

Dra. Patricia Rayón Villela

Área de Ingeniería y Tecnología

Coordinadora de la Maestría en Inteligencia Artificial de UNIR México

Referencias

- Raschka, S. (2024). Build a Large Language Model (From Scratch). Manning Publications.

- Subramanian, S. (2023). Large Language Model-Based Solutions. Wiley.

- Wei, J., Tay, Y., Bommasani, R., Raffel, C., Zoph, B., Borgeaud, S., … & Le, Q. V. (2022). Emergent Abilities of Large Language Models. Transactions on Machine Learning Research (TMLR). https://arxiv.org/abs/2206.07682